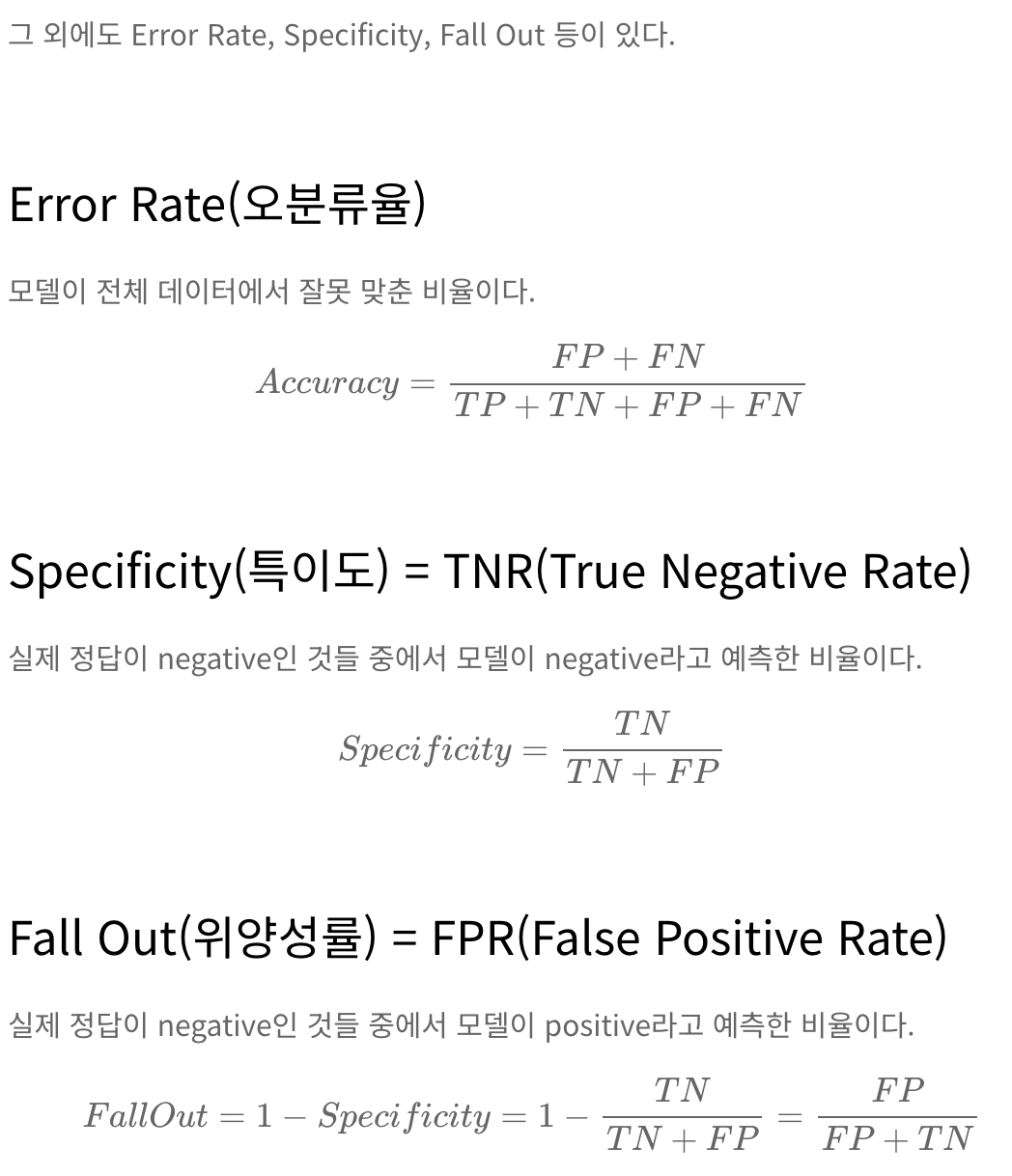

confusion matrix와 분류 성능 평가 지표

| 실제값 / 예측값 | positive | negative |

| positive | TP | FN |

| negative | FP | TN |

분류 성능 평가 지표

-Accuracy : 정확도

-Precision : 정밀도 (PPV : positive predictive value)

-Recall

-F1 score

그 외

-Error rate : 오분류율

-Specificity : 특이도 (TNR : true negative rate)

-Fall out : 위양성률 (FPR : false positive rate)

1) 정확도

전체 문제 중 정답을 맞춘 비율

정답을 맞춘 경우의 수 = TP + TN

accuracy=(TP+TN) / (TP+FP+TN+FN

**단 imbalance data의 경우 accuracy 만으로 제대로 분류했는지 알 수는 없다. (정상:비정상 = 9:1)

그렇기에 recall과 precision을 사용함

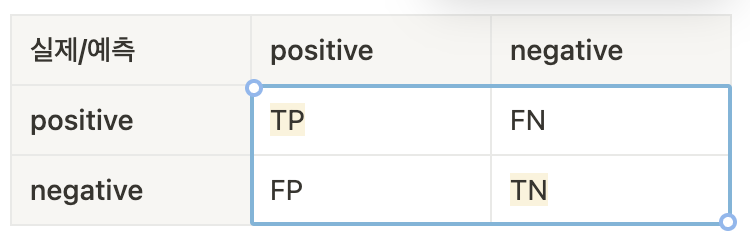

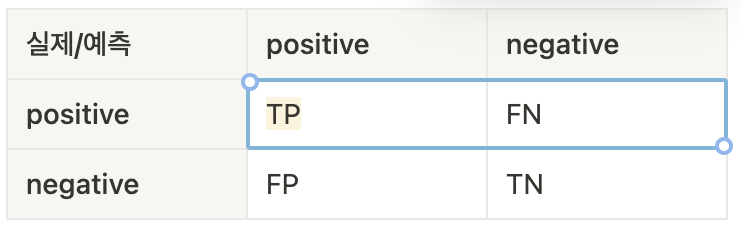

2) precision : 정밀도

positive predictive value : PPV

모델이 p라고 예측한 것들 중 실제 p인 비율 : 모델이 n을 p라고 잘못 예측하면 안되는 경우(imbalance data)에 중요한 지표가 될 수 있음

precision = TP / (TP+FP)

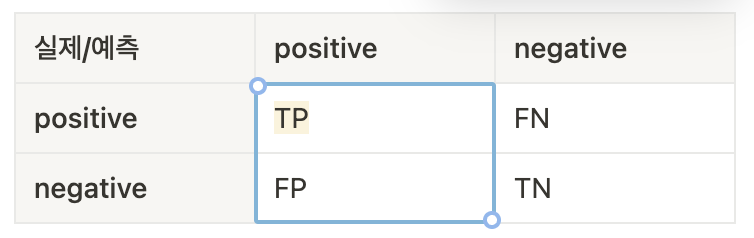

3)recall : 재현율 = sensitivity : 민감도

true positive rate : TPR

실제 정답이 p 인 것 중 모델이 p라고 예측한 비율 : 모델이 p를 n이라고 잘못 예측하면 안되는 경우 중요한 지표가 됨

recal = sensitivity = TP / (TP+FN)

**recall를 높이기 위해선 FN을 낮추는 것이 중요

4) F1 score

recall과 precision의 조화평균 (두 지표는 상호보완적인 평가지표이므로 f1 score 사용)

precision과 recall이 한쪽으로 치우치지 않고 모두 클 때 f1 score 값도 큼

F1=2*precision*recall / (precision+recall)