분야 : Diffusion inpainting

전체 정리

INTRODUCTION

METHOD

EXPERIMENT

LIMITATIONS

CONCLUSION

전체 정리

point

- 특정한 마스크 분포에 대해 학습하여 특화 일반화에 맞춤

=> 자유 형태 인페인팅 적용

임의 mask로 지정된 부분에 새로운 contents 추가

DDPM 기반 인페인팅 접근 방식 RePaint 제안

INTRODUCTION

Inpainting

이미지의 손실된 부분을 시각적 및 의미적으로 그럴듯한 요소로 채움

추후 이미지 -> 오디오로 확장 가능

기존 이미지 인페인팅 기법

- 주변 영역 픽셀을 가져옴

주변 영역에 누락된 부분을 채우기 적합한 픽셀 정보가 없을 수 있음

=> 사실 상 기존 이미지 인페인팅 기법은 누락된 픽셀값의 복원 정도에서 그침

이미지는 임의의 픽셀값 더미에서 그치는 것이 아니라 픽셀값의 공간 모음이다

이 작업을 단지 손실 값 대체 문제로만 취급하는 것은 비합리적!

그렇다면 이미지 인페인팅의 missing value들을 CNN을 통해 예측한다면?

인페인팅의 조건

- 기존 이미지의 나머지 부분과의 조화

- 의미론적 타당성

- 이미지의 대부분이 극단적으로 누락된 경우도 해결 가능해야함

=> 기존 모델의 경우, 특정한 마스크 분포와 함께 훈련되어 새로운 마스크에 대한 유연한 생성이 힘듦

본 논문에서 극복해야할 문제점

Denoising Diffusion Probabilistic Model : DDPMs

DDPM의 전개

DDPM의 forward process는 기본적 diffusion model과 동일하게 데이터에 가우시안 노이즈를 더하는 형태로 정의됨

=> DDPM의 전개 과정은 매우 복잡하다

아주 간단하게 설명하자면 diffusion에서와 동일하게 loss function을 최소화하는 것을 목적으로 하며 위 diffusion 설명에서 도출된 loss식의 각 요소를 최소화해보면? loss function을 normal distribution 간의 KL divergence를 계산한 식 or epsilon에 대한 식으로 표현할 수 있으며 어느 시점의 이미지 (Xt-1)이든 샘플링할 수 있다

관련 연구

큰 이미지 데이터셋의 이웃 픽셀들을 사용해 missing region을 채움

- image inpainting

기존 모델인 GAN의 경우, 텍스처 합성은 잘되지만 의미론적 합성은 어려움

=> VAE 기반 네트워크 제안 / 인페인팅 작업 개선 레이어 도입 / 불규칙 마스크 처리 autoregressive method 등의 대안

=> styleGAN, 사전 지식을 사용해 누락 영역 인페인팅하지만 특정 시나리오로 제한됨

=> DDPM 기반 접근법을 사용해 유도된 이미지 합성

...

METHOD

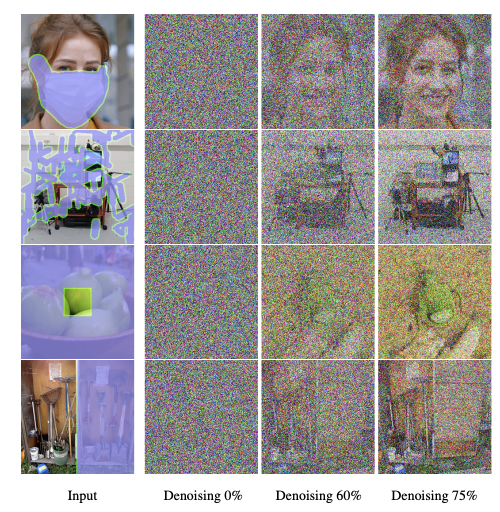

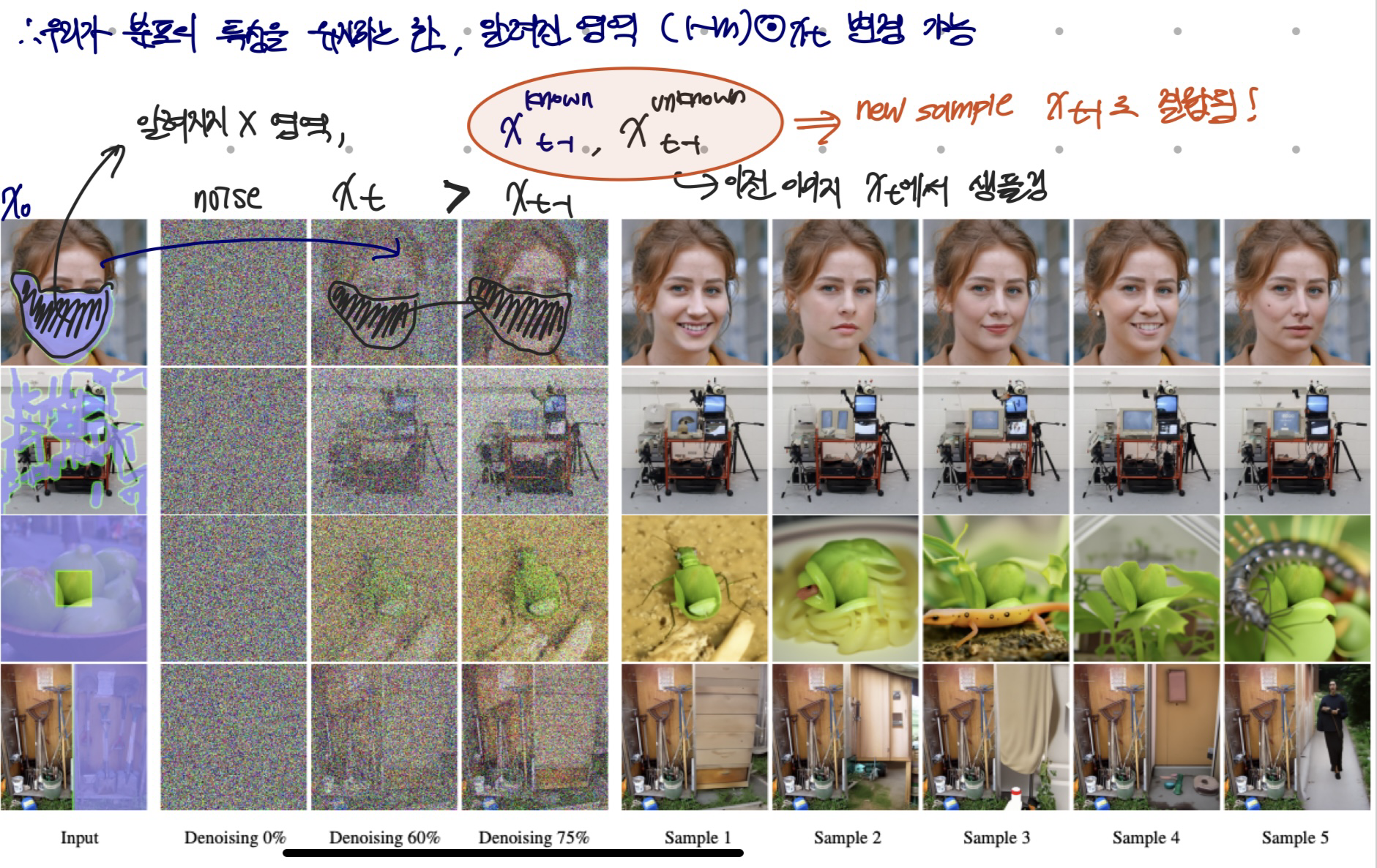

conditioning on the known region

인페인팅 목표 : 마스크 영역을 condition으로 사용해 이미지의 누락된 픽셀 예측

- 원본 이미지 : x

- 알려지지 않은 픽셀 : m ⊙ x

- 알려진 픽셀 : (1 − m) ⊙ x

* Xt에서 Xt-1로의 모든 역 단계는 오직 Xt에만 의존함 : 마르코프 체인

마르코프 성질을 가진 이산시간 확률과정

위 성질을 사용해 어느 시점이든 중간 이미지 Xt 샘플링 가능

Xt-1의 알려진 영역 = X0의 알려진 영역에서 sampling

Xt-1의 알려지지 않은 영역 = Xt에서 sampling

resampling

생성된 영역 Xt-1의 알려지지 않은 부분에 포함된 정보의 일부는 Xt의 알려지지 않은 부분에 존재

- 출력을 Xt-1에서 다시 Xt로 확산 : reverse process

- 출력을 축소하며 다시 노이즈를 추가하는 과정이긴 하지만 Xt의 알려지지 않은 정보가 Xt-1의 알려진 정보와 더 적절한 조화를 이루어 conditional information 포함

=> resampling은 표준 확산 속도를 느리게 하는 것과 동일하게 실행 시간을 증가시킴

=> 확산 속도를 줄여, 노이즈 제거 단계에서 추가된 분산에 대한 차이를 줄임

보다 더 자연스러운 생성 이미지 도출 가능

EXPERIMENT

Implementation Details

dataset은 ImageNet과 CelebA-HQ

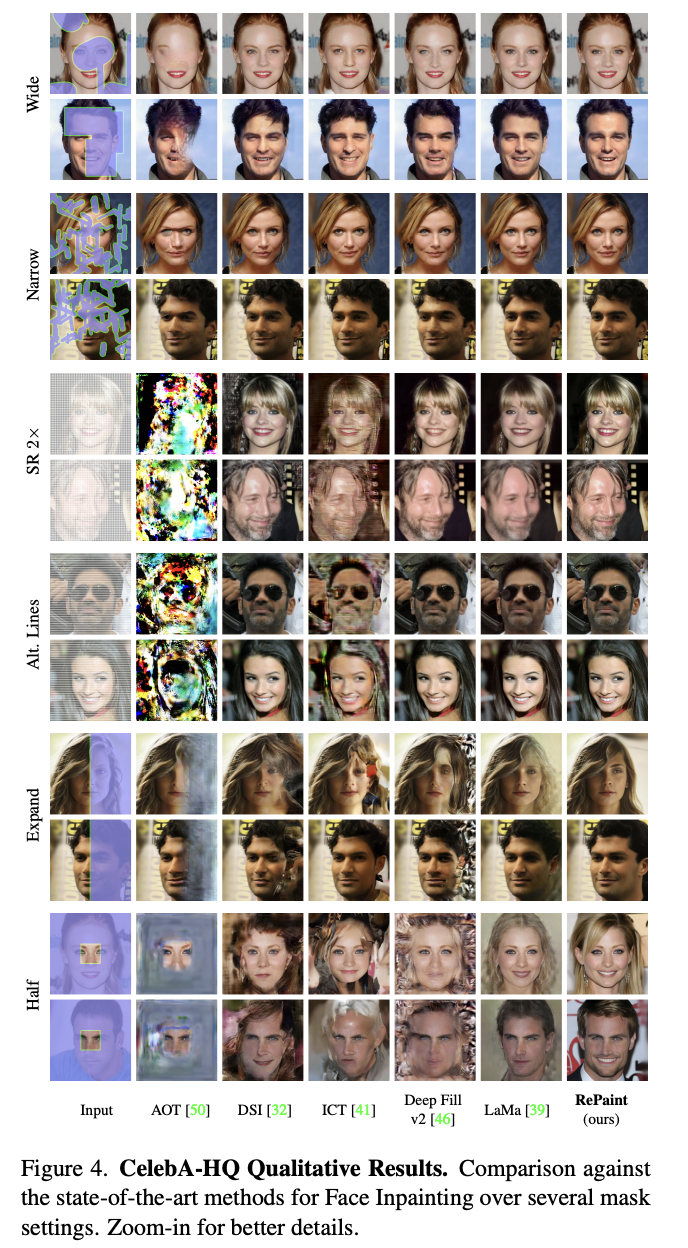

적용 모델은 AOT, DeepFillv2, LaMa, DSI, ICT, RePaint

GAN 기반 접근법 autoregressive 기반 접근법

Metrics

1) 사용자에게 2가지 다른 인페인팅 결과를 두고 어느 이미지가 더 현실적인지 택 1

2) LPIPS 측정치 적용

comparison

4가지 도전적 마스크를 통해 robust한 평가 진행

=> 일반적인 방법인 특정 mask에 의해 학습되어 생성되었다면 해당 마스크 overfitting 가능성 존재

하지만 본 논문은 특정 마스트에 대한 훈련을 하지 않아 다양한 유형의 마스크에 유연한 대처 가능

+ repainting은 유의미한 채우기가 가능하지만 다른 방법들은 텍스처 복사, artifacts를 만드는 수준에 불가

LIMITATIONS

- 매우 선명하며 유의미한 이미지 생성 가능 => but, 이미지 당 DDPM 최적화 과정의 속도가 기존 GAN or autoregressive 방법들보다 상당히 느림 => 실시간 응용 프로그램에 적용하기는 힘들다

- 극단적 마스크의 경우, RePaint가 매우 현실적이나 유동적인 나머지 Ground Truth 이미지와 매우 다른 이미지를 생성할 가능성 존재 => 정량적 평가 불가 => FID 점수 적용가능하지만 계산량이 너무 많아져 실현 X 런타임

- RePaint는 조건 없이 사전 훈련된 DDPM에 의존하는 인페인팅 방법 -> 알고리즘이 훈련된 데이터셋에 편향될 수 있음 => 모델은 훈련 세트와 동일한 분포의 이미지를 생성하려 하기 때문에 성별, 나이, 인종 등 동일한 편향 반영 가능

- 얼굴의 익명화에 사용될 수 있음

CONCLUSION

image inpainting을 위한 새로운 노이즈 감소 확률 모델 제시

- 자유 형식 인페인팅을 위한 마스크 자유도를 증가시킴

- 마스크 유형에 관계없이 리얼한 이미지 생성 가능

'Paper Review > Generative models' 카테고리의 다른 글

| [Paper Review] WAVENET: A GENERATIVE MODEL FOR RAW AUDIO, 2016 arXiv (3) | 2024.11.01 |

|---|---|

| [Paper Review] Inpaint-Anything, 2023 CVPR (6) | 2024.10.25 |

| Generative Adversarial Nets : GAN (4) | 2024.09.16 |

| Palette: Image-to-Image Diffusion Models (0) | 2024.02.04 |

| WaveNet : A Generative Model for Raw Audio (DeepMind) (1) | 2023.11.22 |